Creación de cluster HA en Proxmox

Continuamos con Proxmox y Ceph de 0 a 100 parte II. En esta segunda parte crearemos nuestro cluster.

Comentar que todo lo realizado por la interfaz gráfica, puede ser realizado por la consola, para los que estén interesados en profundizar. En estos posts nos centramos en la GUI como es obvio ya que es desde cero, pero como indicamos en la primera parte, no se queden solo con la GUI si lo van a utilizar en producción.

Para empezar necesitamos definir la red por la que se van a comunicar los nodos, para ello en VirtualBox añadimos la segunda tarjeta como red interna, la cual utilizaremos.

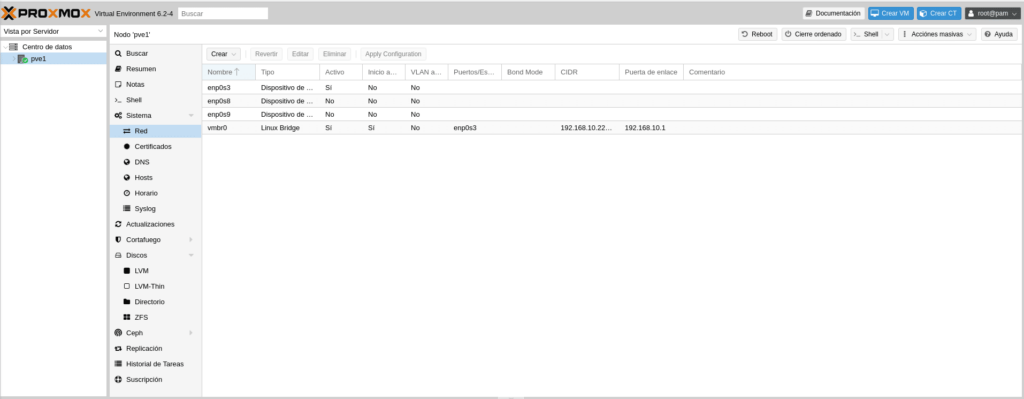

Para empezar entramos en el nodo uno, hacemos click en pve1 y en el menu nos vamos a sistema/red

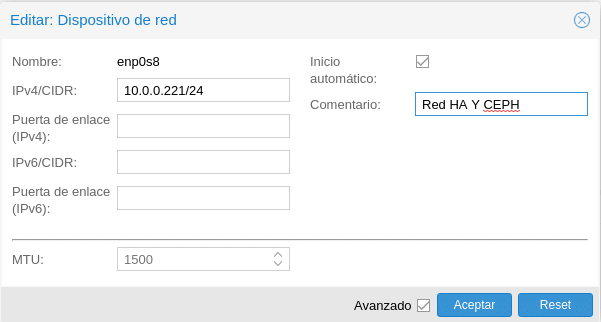

Como podemos observar tenemos un Linux Bridge con la interfaz enp0s3 asociada y la ip de nuestro Proxmox, el cual se creó en la instalación, ahora nos toca utilizar la interfaz enp0s8 que es nuestra segunda tarjeta, que estará dedicada para HA y CEPH. Nos situamos en la interfaz enp0s8 y hacemos click en editar.

En la ventana que nos encontramos, necesitamos rellenar para este caso una IPv4 con la máscara, es al gusto del consumidor, para un laboratorio pondremos para PVE1 la 10.0.0.221/24, PVE2 10.0.0.222/24 y PVE3 10.0.0.223/24 . Corosync tiene un limite de 32 nodos, por lo tanto nos sobran IP con una /24, en producción podemos poner /27 si vamos a llegar a 32 nodos, en este caso con las ips que hemos seleccionado no podríamos ya que la 10.0.0.223 del PVE3 sería la de broadcast con una /27, tendríamos que seleccionar, por ejemplo, la 220,221 y 222. Bueno no me enrollo más sobre redes, ahora añadiremos un comentario para saber que cometido tiene esa red, en este caso "Red HA y CEPH" y muy importante marcar la casilla Inicio automático.

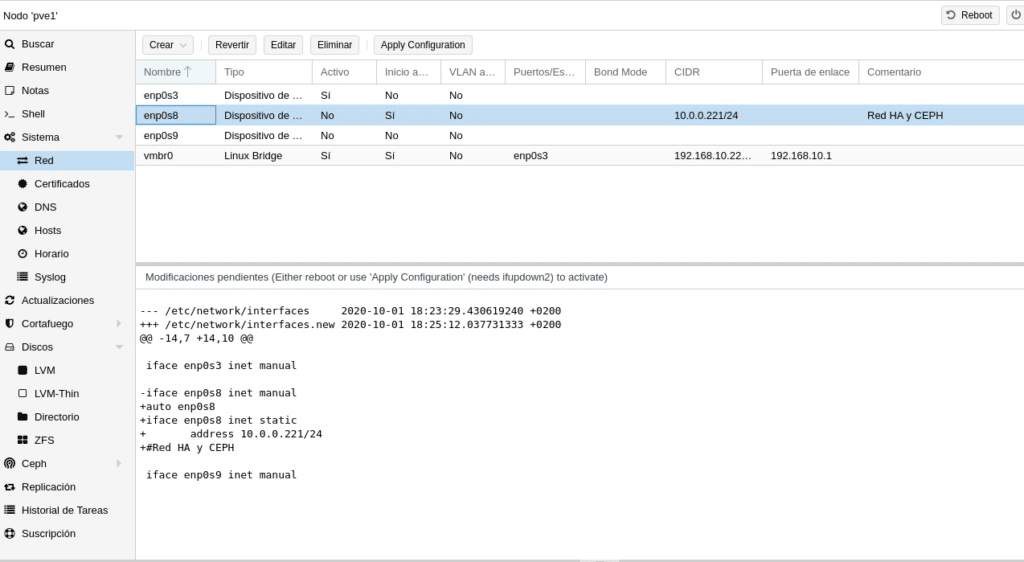

Una vez le damos a aceptar, veremos lo siguiente en la parte de abajo

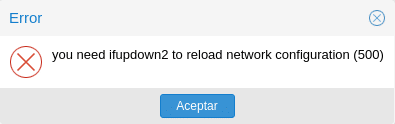

Donde nos dice que hay unas modificaciones pendientes y cuales son, para aplicarlas reinicie o utilice ifupdown2, en versiones anteriores solo te decía que reiniciaras, ifupdown2 es nuevo en está versión y en la gui aparece un Apply Configuration arriba a la derecha, que no aparece en las versiones anteriores. Si le dais os preguntará si queréis aplicar los cambios y al darle a Si obtendréis.

Y esto se debe a que no viene instalado por defecto, posiblemente porque no funciona con interfaces OVS. Para instalar es tan simple como ir a la consola y escribir lo siguiente siempre y cuando tengas una suscripción.

apt install ifupdown2

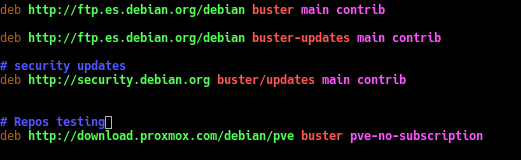

Como no es el caso, podemos utilizar los repositorios sin suscripción donde Proxmox ya te avisa de que no los utilices en producción puesto que no están testeados al 100%, para ellos editamos

nano /etc/apt/sources.list

Y añadimos el repo

deb http://download.proxmox.com/debian/pve buster pve-no-subscription

Quedando de la siguiente manera

Actualizamos como se explicó en el capítulo anterior pero no instalamos nada, solo nos vamos a la consola y escribimos lo anterior mencionado

apt install ifupdown2

Volvemos a editar el sources.list y comentamos el repositorio que hemos puesto con una # delante, la descomentaremos cuando algo que necesitemos solo esté en los de testing sabiendo lo que conlleva.

Hay que tener en cuenta que esto desinstalará ifupdown, si vienes de una versión de Proxmox desactualizada necesitas comprobar que ifupdown está actualizado o por lo menos por encima de la 0.8.35+pve1 o la red se detendrá por completo, escribiendo en la consola ifup –version,

Ahora ya el botón Apply Configuration funcionará a la perfección y no necesitamos reiniciar el nodo. Esto lo podíamos haber hecho en la parte I antes de clonar, pero esta funcionalidad nueva merecía estar en la parte II donde empezamos a tocar redes para ir cogiendo destreza.

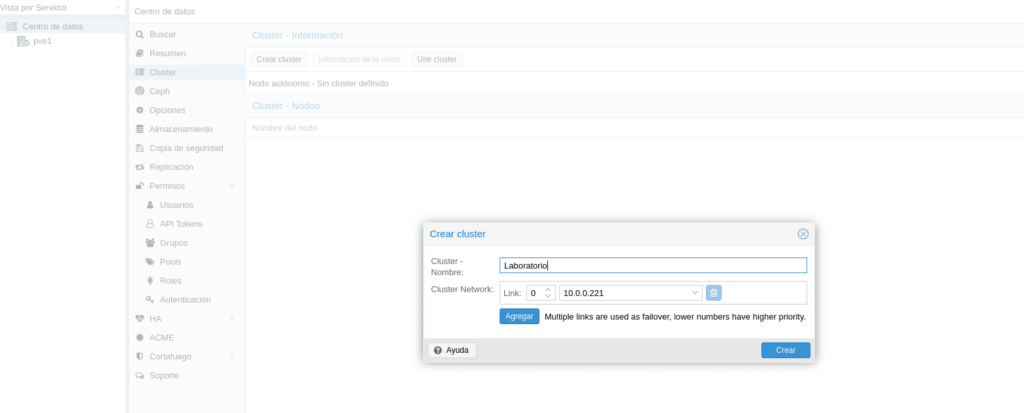

Ya tenemos la interfaz de HA y CEPH configurada, hacemos click en Centro de datos y seguidamente en Cluster/Crear Cluster

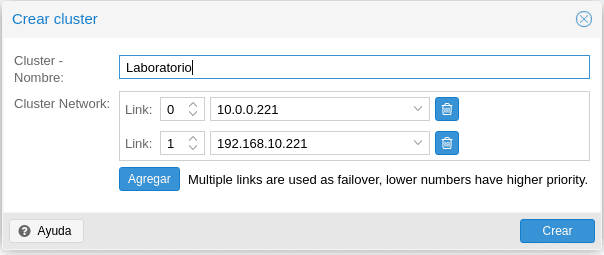

Y sorpresa para los que conozcan versiones anteriores, han metido Multiple links hasta un máximo de 8 para el cluster, hasta ahora teníamos que crearnos un bond de tarjetas y utilizar dicho bond, en esta nueva versión podríamos tener otra interfaz dedicada para HA y CEPH sin necesidad de hacer un bond de tarjetas, aunque esto depende del escenario, ya que con un bond de tarjetas trabajarán simultáneamente, mientras que por links se utilizará por prioridad, teniendo mayor prioridad el número más bajo, es decir, imaginaros que ponemos como backup la de gestión quedaría de la siguiente manera

Fácil eh? Es un ejemplo, no lo hagáis en producción, en producción utilizar 2 tarjetas dedicadas.

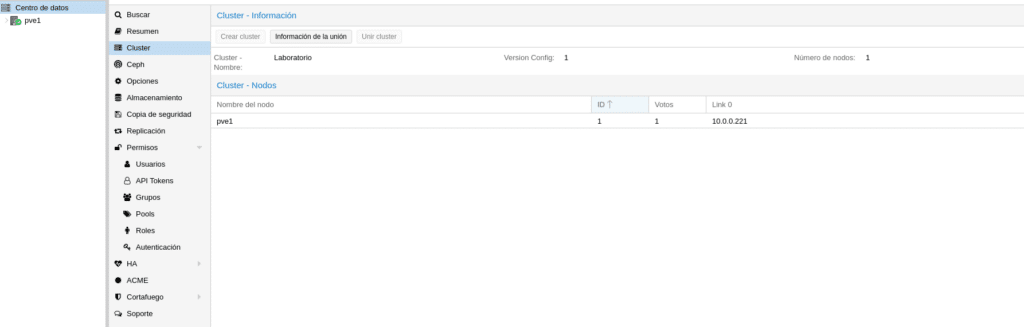

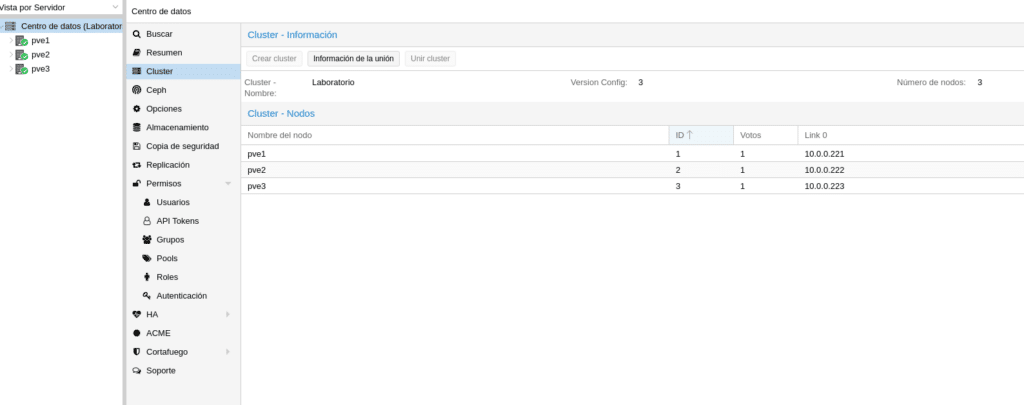

Le damos a crear con nuestra tarjeta de red de HA y CEPH y veremos lo siguiente en el apartado cluster

Como podemos observar nos da los datos de nuestro cluster y arriba un botón que pone información de la unión, lo cual necesitaremos para unir nuestros nodos PVE2 y PVE3, si hubiéramos seleccionado más tarjetas tendríamos la información de los demás links con su IP.

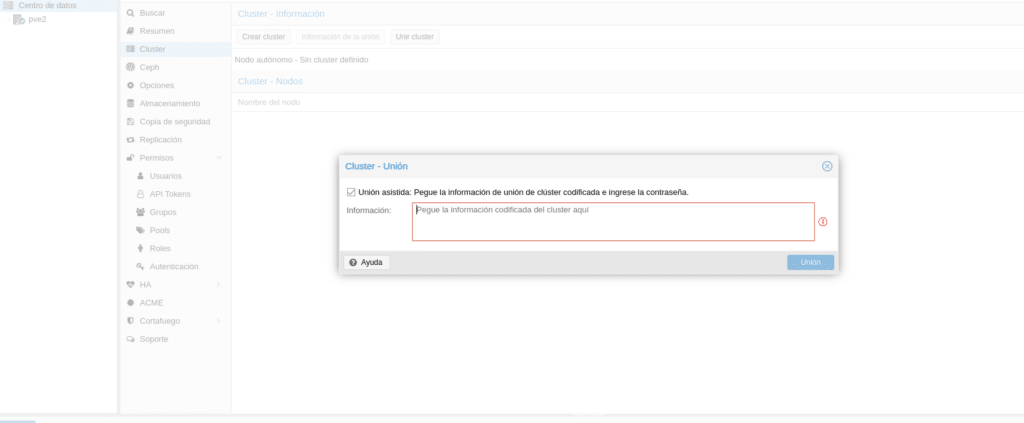

Perfecto, hemos configurado nuestro PVE1 y creado el cluster, ahora configuramos la red de nuestro PVE2 como hemos realizado con PVE1 y la única diferencia es que cuando estemos en el apartado cluster, en lugar de dar al botón Crear cluster le daremos a Unir Cluster, apareciendo lo siguiente.

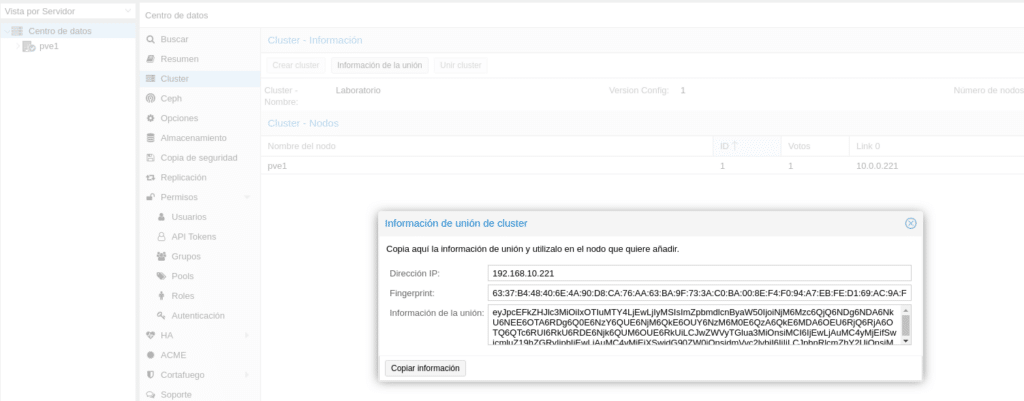

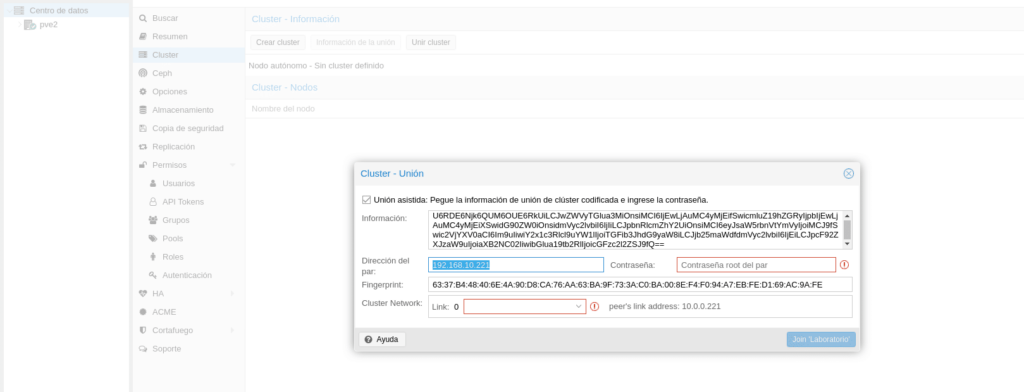

Esta información es la que obtenemos si pinchamos en el PVE1 en el botón comentado "Información de la unión".

Hacemos click en Copiar información y nos dirigimos al nodo PVE2 para pegarla.

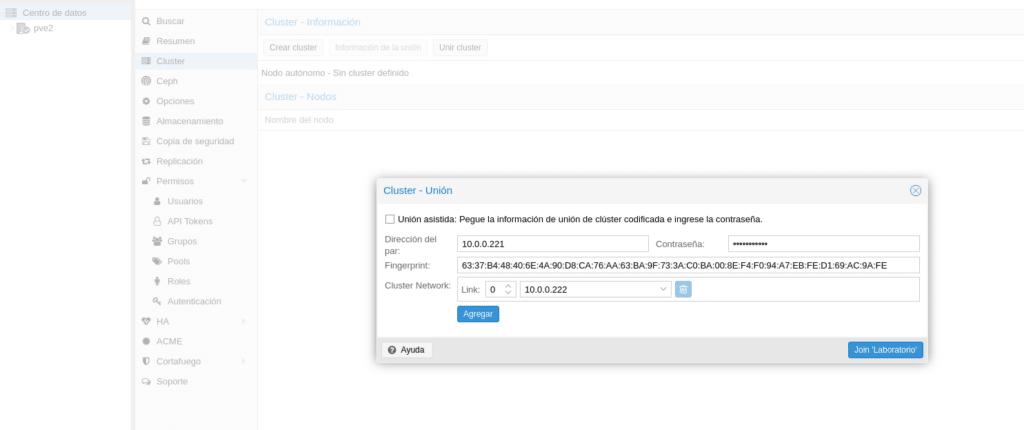

Como veis he seleccionado para resaltar la dirección del par, el cual nos coge la ip de gestión del nodo PVE1 y no podemos modificar, queremos que todo lo relacionado con el cluster vaya por la interfaz HA, pues bien, para poder modificar dicha ip desmarcamos la opción Unión asistida, rellenamos los datos con la IP 10.0.0.221 del nodo PVE1 y seleccionamos los Link que utilizaremos, quedando de la siguiente manera

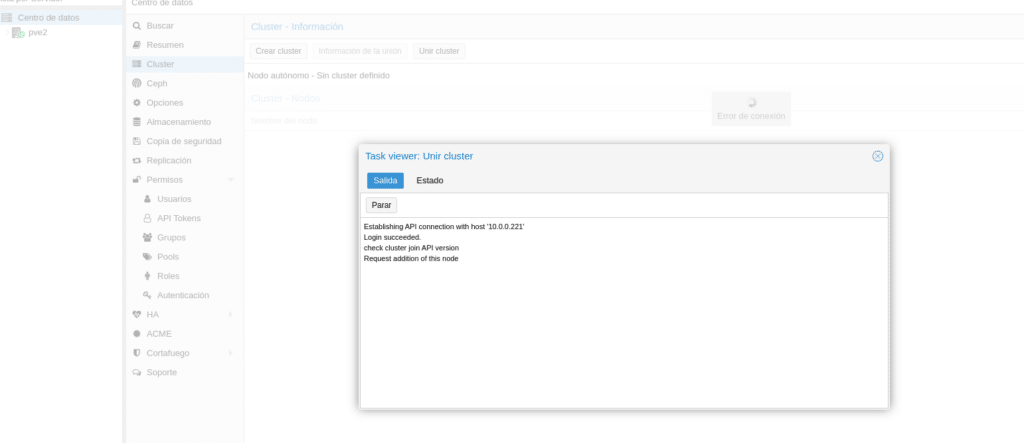

Y hacemos click en el botón Join ‘nombre cluster’ y devolverá lo siguiente donde se observa de fondo un error de conexión, es normal porque habría que refrescar la gui y volver a introducir user y pass, podemos acceder al cluster desde cualquiera de los nodos.

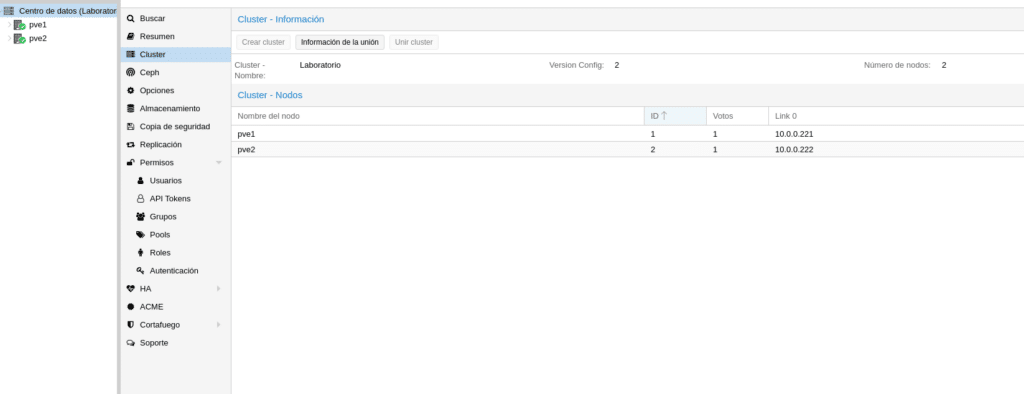

Si entramos en cualquiera de ellos y vamos a la sección cluster ya podemos observar que tenemos 2 nodos en el cluster.

Repetimos el proceso con el nodo PV3 y nuestro cluster quedará

Como podéis ver no ha sido nada complicado y el portátil aguanta de momento 🙂 con los 3 nodos, espero os haya gustado esta segunda parte y que la disfrutéis…Si quieres adquirir alguna de las licencias ponte en contacto con nosotros, somos partner de Proxmox.

Disponible Proxmox y Ceph de 0 a 100 parte III

TL.

Gracias por leer nuestros posts.

Preguntas Frecuentes

Un clúster de alta disponibilidad en Proxmox es una configuración que permite que varios nodos trabajen juntos para garantizar que las máquinas virtuales y los contenedores permanezcan operativos incluso si uno de los nodos falla. Esto se logra mediante la monitorización constante y la migración automática de cargas de trabajo entre los nodos del clúster.

No necesariamente. Proxmox en sus ultimas versiones viene con ifupdown2 instalado, que permite aplicar cambios en la configuración de red sin necesidad de reiniciar el nodo.

Si un nodo falla, Proxmox HA detectará la caída y migrará automáticamente las máquinas virtuales con HA configurado a otro nodo disponible en el clúster. Para que esto funcione correctamente, es necesario que Ceph o un almacenamiento compartido esté configurado correctamente.

Se necesitan un mínimo de 3 nodos ya que Proxmox utiliza Corosync y está basado en quorum. Con dos nodos no habría quorum puesto que cada nodo tendría el 50% ante una caída. Es posible utilizar dos nodos siempre y cuando añadamos un qdevice.